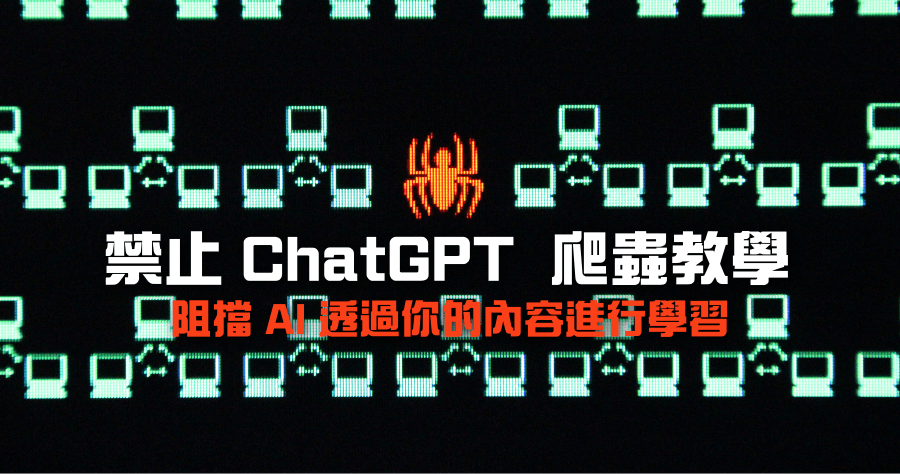

OpenAI 旗下 AI 對話式機器人 ChatGPT 今年爆紅之後,有許多人在探討如何阻擋 AI 機器人利用自己的內容來進行 AI 語言模型訓練,這部分爭議非常大,其實在 OpenAI 的官方文件中就有說明 ChatGPT 的網路爬蟲機器人名為 GPTBot,也有公開爬蟲的 IP 可以讓大家

阻擋 AI 蒐集網站資料,這篇就來跟大家分享如何禁止

ChatGPT 爬蟲機器人來使用你的資料。

透過設定網站中的 robots.txt 檔案,就可以阻擋 GPTBot 來你的網站爬資料,這是一個專門給各式網路爬蟲看的文件,文件中會告訴爬蟲哪些資料不能取用。

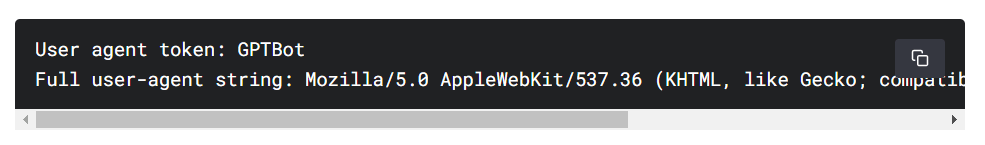

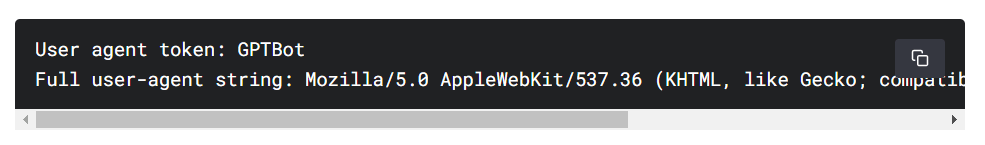

根據 OpenAI 官方文件表示,User-agent 為 GPTBot。User-agent 字串如上圖。下面幫大家列出,可直接複製使用:

User agent token: GPTBot

Full user-agent string: Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; GPTBot/1.0; +https://openai.com/gptbot)

禁止 GPTBot 爬取網站內容

直接將上圖中的文字,加入網站中的 robots.txt 檔案中儲存即可,加入後 ChatGPT 的爬蟲就不會爬取網站資料。禁止內容如下,可直接複製使用:

User-agent: GPTBot

Disallow: /

開放部分內容爬取

除了全部禁止之外,也可以自訂允許 GPTBot 爬取的路徑,Allow 跟 Disallow 後面可以自由加上網站目錄路徑名稱。

User-agent: GPTBot

Allow: /directory-1/

Disallow: /directory-2/

IP 方式阻擋OpenAI 還公布了自家的 GPTBot 使用 IP,因此也可以直接設定 .htaccess 檔案,就可以直接阻擋 GPTBot 爬蟲,以下是 OpenAI 所公布的 IP:

- 20.15.240.64/28

- 20.15.240.80/28

- 20.15.240.96/28

- 20.15.240.176/28

- 20.15.241.0/28

- 20.15.242.128/28

- 20.15.242.144/28

- 20.15.242.192/28

- 40.83.2.64/28

資料來源:

OpenAI

根據 OpenAI 官方文件表示,User-agent 為 GPTBot。User-agent 字串如上圖。下面幫大家列出,可直接複製使用:

根據 OpenAI 官方文件表示,User-agent 為 GPTBot。User-agent 字串如上圖。下面幫大家列出,可直接複製使用: